大模型当私人法律顾问?北大团队推出法律大模型,数据与模型全部开源

大模型当私人法律顾问?北大团队推出法律大模型,数据与模型全部开源

夕小瑶科技说 原创,作者 | 小戏、Python

“要是我有一个学法的朋友就好了”

法律作为我们社会生活的最高指引,其重要性毋庸多言。然而类似于医学,法律又是一个入行门槛非常高的专业领域,想想通过率不到 10% 的法考,显然遇到法律相关的专业问题不太支持我们抄起法条生啃,因此一个理想的场景便是我有一个自己的私人法律顾问,可以自信的说“在我律师来之前,我不会说一句话”

(资料图片)

(资料图片)

事实上,在大家畅想大模型广阔的应用天地时,肯定也想到过将大模型应用于专业的垂直领域,在这些领域大模型所擅长的“问答”必然能带来比纯粹的聊天机器人或是智能客服更多的想象力。但是问题似乎也显而易见,垂直领域的大模型缺少对领域特定知识的训练语料,同时,在医学、法律这样的需要高度“可信”的领域中,大模型的机器幻觉也会带来许许多多的问题。

中文法律大模型 Lawyer LLaMA

最近,北京大学王选计算机研究所的团队推出了一个中文的法律大模型 Lawyer LLaMA,通过在大规模法律语料中进行训练,系统学习中国的法律知识体系使得模型可以掌握中国的法律知识并应用于中国的法律实务。让我们上图片举个栗子:

对比上图左侧的BELLE(Be Everyone"s Large Language model Engine)模型,如果提问“中国的法定结婚年龄”,可以看到 Lawyer LLaMA 给出了一个正确的,并且更像是 Lawyer 的回答。并且,即使是提供了必要的法律条文,如上图问题B,BELLE 也无法给出一个正确的回答,而 Lawyer LLaMA 则有理有据的颇具专业性的很好的回答了这个问题。

大模型研究测试传送门

GPT-4传送门(免墙,可直接测试,遇浏览器警告点高级/继续访问即可):

https://gpt4test.com

其实从 BELLE 的回答中也可以看出,直接将这样一个大模型套在专业的垂直领域下往往会出现许多问题,作者团队认为,要使得大模型可以很好的适应法律领域的特殊要求,必须要满足以下三个条件,分别是:

1、精确的表意,避免歧义:在法律领域中常常会有仅仅更换一个字词,就会导致法律关系构建出截然相反的结果,譬如中文中定金与订金仅相差一个字,但是其含义与法律效力在合同法中却完全不同;

2、理解与区分法律术语:在法律中,有许多特有的特定词汇,许多术语仅仅出现在法律领域中,如法人这个概念,而还有更多术语可能在法律领域与日常生活领域拥有着不尽相同的含义,也需要模型加以区分;

3、能够理解实际情况:除了对法律术语与法律分析要有基本的了解与系统的掌握以外,模型还应当具有精确理解现实生活问题的能力,即模型需要拥有一个应用法律理论来解决特定问题的核心能力。

基于上述理论,作者团队便基于开源的 LLaMA 模型期望通过以下几步解决法律领域大模型的适用问题:

法律相关知识注入:通过收集大量法律领域的原始文本,如法律条文、司法解释与国家法律文件,对原始模型使用新数据进行继续训练;

特定领域技能习得:一个良好的法律大模型应该能够解决法律领域的常见问题,如概念解释、案例分析与法律咨询,因此作者收集了一组实际的任务案例,使用 ChatGPT 生成相应答案从而进行监督微调,以使得模型具有解决法律领域特定任务的能力;

信息检索减轻幻觉:为了减轻大模型的机器幻觉问题,作者同时引入了一个信息检索模块,在生成每个回复之前,都首先利用用户的查询与上下文检索相关法律条文,基于这些法律条文再去生成相应回复。

通过以上三步,作者团队便成功的完成了 Lawyer LLaMA 的构建,Lawyer LLaMA 的整体运作流程如下图所示:

先跳开训练的细节,让我们定性的看一波 Lawyer LLaMA 的回复表现,首先在一个法律概念解释的任务里,当要求模型解释“什么是夫妻共同财产”时,BELLE 与 ChatGLM 都给出了错误的回答,从这两个大模型所犯的错误中可以看到,法律领域的概念解释并不是一个简单的问题,如 BELLE 虽然理解了夫妻共同财产的概念,但是却错误的使用了“任何财产”这样的表达,而 ChatGLM 则错误的将共同债务视为共同的财产类型,甚至对财产分割开始胡言乱语,而只有 Lawyer LLaMA 简明准确的回答了这样一个概念:

更进一步的,作者同样要求 BELLE 与 ChatGLM 以及 Lawyer LLaMA 区分两个相似的法律概念,即离婚与无效婚姻,可以看到 BELLE 和 ChatGLM 都误解了离婚的概念,并且使用了口语化的容易导致歧义的表达,如 BELLE “从未存在过” 这样非常不专业的回答,也只有 Lawyer LLaMA 给出了一个看起来更加专业可信度更高的回复:

除了上述名词解释性的题目外,Lawyer LLaMA 在“应用题”法律实务咨询上也表现良好,如下图所示,关于一个离婚问题,BELLE 与 ChatGLM 的回复都存有一些逻辑问题甚至胡言乱语,这样的回复显然不能作为法律实务咨询的回复,而 Lawyer LLaMA 则非常清晰明了的回答了上述的咨询问题:

同时,在作者的实验中还发现, BELLE 与 ChatGLM 这两个模型事实上并不能理解法律条文的含义,如下面的案例中,BELLE 引用了一个完全无关的条文,而 ChatGLM 则混淆了无效婚姻与可撤销婚姻的概念,都导致的回答错误。

Lawyer LLaMA 的构建

为了成功构建一个法律领域的大模型,遵循前文介绍的三步,作者为了解决使用的开源大模型 LLaMA 的中文理解问题,作者团队首先先使用中文通用语料库对 LLaMA 进行训练,这些中文语言抽样自 WuDaoCorpora、CLUECorpus2020 以及维基百科的简体中文版。在完成中文能力增强之后,作者开始着手构建中文法律语料库,这样一个法律语料库主要来源于中国各级法院网站的文章、判决文书、法律条文、司法解释、法庭新闻以及各种法律科普文章等等。

同时,作者使用了“天下第一考”法考的考试题来让大模型进行刷题训练,作者采用了 JEC-QA(A Legal-Domain Question Answering Dataset) 数据集的 26365 个单选与多选问答对来对模型进行训练,并且为了增强模型对“解题过程”的理解,作者又使用了 ChatGPT 为模型生成问题解释,生成的解释示例如下所示:

而对于法律咨询问题,作者主要使用一个开源的法律咨询数据集对问题进行抽样,同样,使用 ChatGPT 生成问题回答,区别于上文直接的采用 ChatGPT 生成问题解释,在面对法律咨询这种更加复杂的问题时,作者综合使用单轮与多轮对话、赋予 ChatGPT 律师角色、设计 Prompt 等等以提升回复的准确性,并且为了保证“有法可依”,作者团队还设计了一个法律条款的检索器,要求 ChatGPT 正确引用法律条款以生成回复。

在收集了大约 16000 个单轮回答与 5000 个具有 2-3 轮对话回复之后,模型整体训练流程可以被表示为以下这张图片:

如上图所示,整体训练流程经过了增强汉语能力(s1),法律知识注入(s4),下游任务训练(s7)以及法律条文检索(s12)四大步,逐步增强模型解决法律问题的能力,值得注意的是其中最后一步法律条文检索,在作者的实验中发现,现有大模型即使学习到了相关的法律条文条款,但是仍然学不会在生成回复时正确的引用它们,经常会出现参考不相关的条文,错误替换含义不同的法律概念等等问题,因此作者引入了法律条款检索模型,针对法律咨询的用户问题,要求专业律师标注最多 3 个必要的法律条文,再使用 RoBERTa 训练了一个在相关检索测试集上正确率 85% 的法律条文检索模型。但是当检索到的法律条文与用户输入相连时,作者发现模型也会倾向于引用所提供的所有法律条文,而不去区分它们是否真正与当前问题场景相关,因此,论文又加入了许多不相关的文章到模型的上下文中,以迫使模型忽略那些“不重要的信息”,并且添加了“参考文献中可能有不相关的内容,请避免在回复时引用那些不相关的文章”的 Prompt。

最终实验基于 LLaMA-7B 训练完成 Lawyer LLaMA 的构建,基于模型训练的s1-s12个阶段,以及(1)-(6)种训练语料,作者评估了模型在训练各个阶段在中文通用任务、英文通用任务以及中文法律任务中的模型得分,可以发现模型在中文语料训练后在中文问答数据集 C3 中获得了 5.3% 的正确率提升,并且其英文能力没有出现下降。同时,比较好玩的一点是,在学习完法考之后,模型的中文 NLI 能力(CMNLI)也得到了提升,提升了 9.3%,尽管法考的试题数据中没有 NLI 的问题,因此模型似乎是通过对法考题目以及推理判断过程的学习增强了中文的理解与推理能力(不愧是法考)。

而在法律领域,通过区分法考数据(JE)中的概念辨析(JE-C)与情景规划(JE-S)问题以及婚姻判决问题(CAM)与财产判决问题(CAP)构建评估数据集,可以发现,s12 的模型在大多数任务中都优于 s0,准确率在 CAM 与 CAP 中提升幅度都超过 10%,但是比较 s0、s4、s7 下的 JE-C 与 JE-S 的结果,可以发现从 s0 到 s7,JE-C 提升 3.9%,JE-S 提升 2.85%,但是当引入问题咨询的数据后,JE-C 与 JE-S 的准确率都出现了下降,作者认为主要原因可能来自考试问题与咨询问题之间的不相似性。

总结与讨论

这篇文章提出了法律这样一种垂直专业领域下的大模型训练方法论,其实不仅仅是法律,许多专业细分领域的大模型训练都可以从这篇论文中找到借鉴,总结来说,就是“有监督微调”让模型学习必要的专业知识,“检索模块”提供必要的外部证据以解决模型的可信性问题。这篇论文的代码也开源在了 Github 中,并且计划进行 Lawyer LLaMA 13B 的内测体验,感兴趣的小伙伴可以关注下方论文与代码链接~

论文题目:

Lawyer LLaMA Technical Report

论文链接:

https://arxiv.org/pdf/2305.15062.pdf

代码链接:

https://github.com/AndrewZhe/lawyer-llama

标签:

上一篇:布莱泽奥特曼前四集简介:全是新怪兽,阿斯加隆第3集登场

下一篇:最后一页

- 大模型当私人法律顾问?北大团队推出法律大模型,数据与模型全部开源

- 布莱泽奥特曼前四集简介:全是新怪兽,阿斯加隆第3集登场

- 一笔一笔画公主怎么画_教我画画一笔一画公主 天天热门

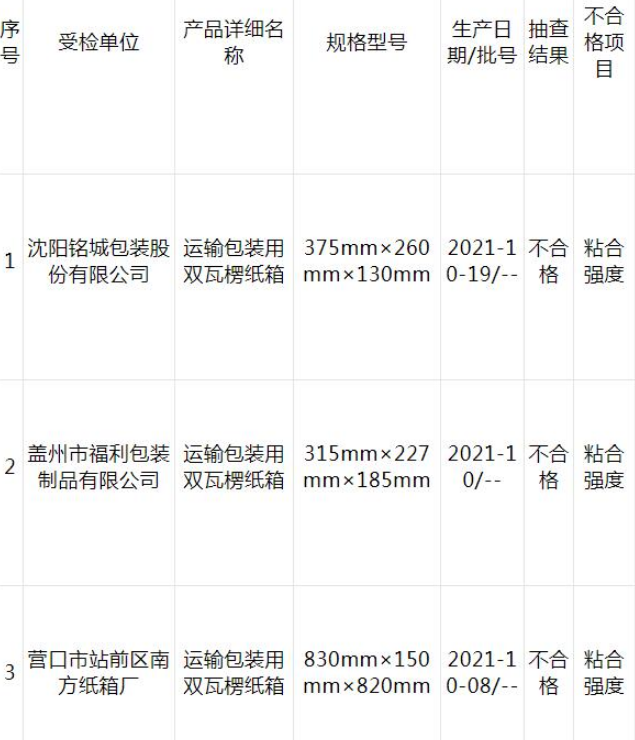

- 全球看热讯:广东检出14批次不合格食品,涉及微生物污染、农兽药残留、食品添加剂使用等问题

- 世界热文:河南上市公司上演“摘帽潮”!又一只豫股撤销风险警示

- 10岁以上男孩生日快乐礼物 全球焦点

- 全体起立!!速来宁波向快乐崇拜

- 防止肠息肉发展成结直肠癌 肠镜检查很关键 世界报道

- 清平调其一翻译及赏析(清平调)_全球快播报

- 新开源(300109.SZ):医疗板块经营环境持续向好,预计今年可以扭亏 天天热闻

- 平天冠衮龙袍 平天冠 全球快播

- 没患糖尿病却被注射胰岛素?患者去世后家属质疑医院误诊,院方否认,卫健委介入

- 全球快看点丨剑与远征全球锦标赛怎么玩(剑与远征全球锦标赛奖励是全领么)

- 如何走进双鱼女的内心(双鱼座是“海王”吗)|热点

- 世界快播:篮协官宣男篮18人集训大名单:周琦领衔 姚明领队&郭艾伦无缘

- 西瓜视频怎么导入U盘_西瓜视频怎么下载

- 当前热文:海航提出空姐“超重”10%要立即停飞减重,是否涉嫌违法?

- 世界观察:林森生物董事长于景堂涉嫌妨害药品管理罪被南京市公安局江北新区分局执行逮捕

- 全球热推荐:永东股份(002753.SZ)2022年度拟每10股派0.16元 6月21日除权除息

- 天天关注:何时提价、如何分红?贵州茅台高层在股东大会上回应这些热点

- 阳了的祝福语简短暖心短句_全球热议

- 电影《碟中谍7:致命清算(上)》官宣定档7月14日

- 天天简讯:日经股指上涨

- 世界讯息:2023浙江工贸职业技术学院拟聘用人员公示

- 美媒:美国经济不平等状况日益加剧 两党政策成幕后推手-当前关注

- 世界快讯:海南三亚口岸2023年鱼苗出口季结束

- GGII:预计2030年中国(半)固态电池对高镍材料需求超40万吨

- 乌军反攻出乎意料,6个旅拼死猛攻,骸骨遍野,美国发现大事不好-天天速看料

- 世界热门:兰州,到底需要怎样的开发商?

- 2岁宝宝肚子胀气吃什么食物_肚子胀气吃什么食物

- 每日播报!美国中央司令部:一架直升机在叙利亚发生事故,22名美军人受伤,敌方未开火

- 4399大排档怎么帮好友端菜_4399大排档

- 天天热门:川大:依规依纪处理!曝光大叔的女学生到底该不该被原谅?

- 农行庆阳分行开展“助力高考”暖心服务活动

- 环球速看:【奔跑的“三夏”】中国丰收地图:风吹麦浪的盛夏

- 即将上市\公布预售,这三款新能源车谁最有诚意?

- 急求线索!全网寻找这个人 环球微资讯

- 当前报道:韩国官二代考公务员,靠“我爸是某某”?

- 【数据揭秘】融资客最看好个股一览

- 电脑怎么更改鼠标样式?电脑鼠标箭头怎么换外观? 每日观察

- 龙岩:项目攻坚战犹酣

- 已有34家!国家级文化产业示范园区建设有哪些新看点-热推荐

- 赛尔号希路达进化的分支条件_赛尔号希路达技能表

- 天天通讯!摩根士丹利预计硬着陆风险将提振美元 拉低美债收益率

- 世界即时看!文昌航天科普中心13日起恢复正常营业

- 环球今日讯!众合科技:拟20亿元投建半导体级抛光片生产线项目

- 逆水寒点卡多少钱一个月_逆水寒点卡收费标准

- 【独家】安徽省甫存建筑劳务有限责任公司

- 【环球时快讯】新编企业经营法小全书_关于新编企业经营法小全书简介

- 绿色属于暖色还是冷色_暖色连冬

-

iphone已停用怎么连接itunes解锁_iphone已停用快速解锁 环球热议

大家好,小评来为大家解答以上问题。iphone已停用怎么连接itunes解锁,

-

杨梅的功效与作用及禁忌(杨梅抽真空能放几天)

杨梅中含有丰富的水分及糖分,很容易滋生细菌而腐坏,所以它的保存时间

-

寓言中的理查德·阿约德 (Richard Ayoade) 的选角受到启发,预告片的基调也很完美

Playground可能正在烹饪一些寓言式的东西。微软的XboxShowcase让我们第

-

【热闻】场面温馨!三都:苗族村民芦笙欢送驻村第一书记

近日,贵州省财政厅派驻三都县普安镇重阳村的驻村第一书记张小平任期结

-

信达地产(600657.SH)2022年度拟每股派0.04元 6月21日除权除息

智通财经APP讯信达地产600657600657SH发布公告公司本次利润分配以方案

-

快对搜题怎么搜单题 快对作业拍照搜题步骤一览 天天热议

快对搜题怎么搜单题快对作业拍照搜题步骤一览,

-

苹果Vision Pro出货量,索尼“说了算”?

周一,韩国媒体TheElect报道,苹果VisionPro面板供应商索尼将OLEDoS(

-

全球短讯!周周谈|马自达直面“塞车”梗,奔驰自动驾驶再下一城

马自达邀请梁家辉代言新车,可谓一波赚足眼球的成功营销。不过,梁家辉

-

每日速递:RTX 4060将提前月底上市 2399元起售

RTX4060将提前月底上市2399元起售

-

异动快报:北方股份(600262)6月12日13点16分触及涨停板|世界热推荐

6月12日盘中消息,13点16分北方股份(600262)触及涨停板。目前价格21

-

天天热文:卫生统计学学习指导与习题集第二版(卫生统计学学习指导与习题集)

当前大家对于卫生统计学学习指导与习题集都是颇为感兴趣的,大家都想要

-

通策医疗跌跌不休:口腔行业还算不算长坡厚雪?-当前讯息

且听业内人士深度解读。解读新商业的财经新媒体,报道资本市场,解读上市

-

动态焦点:《变形金刚7:超能勇士崛起》内地票房已突破2亿元,观影人次超536万

《变形金刚7》为这一“变形金刚”IP的前传,剧情讲的是超级反派“宇宙

-

【时快讯】央行今日开展20亿元7天期逆回购操作

为维护银行体系流动性合理充裕,2023年6月12日人民银行以利率招标方式

-

视点!高管接连出走,自动驾驶动荡前行

高管接连出走,自动驾驶动荡前行2022年下半年以来,L4级别自动驾驶赛道

-

三去一降一补具体指什么_供给侧结构性改革是什么意思

1、供给侧结构性改革旨在调整经济结构,使要素实现最优配置,提升经济

-

楚人学舟文言文翻译道理_楚人学舟文言文翻译

1、【原文】楚人有习操舟者,其始折旋疾徐,惟舟师之是听。2、于是小试

-

答辩,新鲜热辣的答辩|今日报

除了名字叫赘婿,角色名字有些相同之外,愣是没找到一处原著的剧情。全

-

环球热消息:48个班!遂宁一公立学校今年9月投用

遂宁又一所学校9月将迎来学生快来一探究竟6月9日,记者在遂宁高新区遂

-

龙爸无双100集电视剧免费观看

万言风本是首富万家大少爷,因被人陷害流落民间,入赘叶家,没想到女儿

-

旱碱麦成“名片”迎来丰收 盐碱地特色农业开出“增收花” 当前热点

央视网消息:眼下,在河北省沧州渤海新区黄骅市,旱碱麦迎来了收获期。

-

长安大学学子以“三色”模式助力陕西乡村振兴

陕西农村集体经济发展已经形成了极具地域特色的不同发展路径,长安大学

-

真金不怕火炼!掘金3-1热火,NBA总冠军只差一步

真金不怕火炼!掘金3-1热火,NBA总冠军只差一步

-

今年端午假期或成近五年最火端午

端午节,又称端阳节、龙舟节、重午节、重五节、天中节等,日期在每年农

-

75部影片已定档,暑期档票房有望冲击150亿

从6月1日至8月31日,跨度长达三个月的2023年暑期档正式启幕。和春节档

-

怎么查社保卡办理进度 视点

1、社保卡办理进度步骤:(以北京社保保障卡为例): 登录北京市社

-

专业洗发水加盟_专业洗发水|每日时讯

1、你好,一般专业的洗发水根据功能会有分四种:一种是滋养烫染后受损

-

金蝶报表acct函数_acct函数是什么意思 当前看点

1、acctabbr account计算;账目;accountant会计师;accounting会计;。本文

-

中铁山桥集团有限公司招聘(中铁山桥集团有限公司)

1、是全资国有企业。2、属于中铁股份全资子公司。3、中铁山桥集团有限

-

四川锂矿资源储量占全国总量57% 具备采矿权锂矿储量达1.58亿吨|新动态

四川省内现已具备锂矿开采能力近155万吨,基础锂盐产能54万吨

-

2023西藏高考结束,听他们怎么说! 动态焦点

6月9日,随着最后一门藏语文考试的结束,2023年西藏自治区高考正式落下

-

大腿内侧湿疹怎么办_大腿内侧湿疹

1、湿疹是由多种内、外因素引起的真皮浅层及表皮炎症。2、一般认为与过

-

昌都宝藏男孩,完成了5400公里的G318骑行

我叫肖遥,是一个生活在西藏昌都的骑行爱好者。国道318是中国第二长国

-

在铁路12306买卧铺票也可以在线选铺位了!手把手教你怎么操作

在铁路12306买卧铺票也可以在线选铺位了!手把手教你怎么操作---记者从

-

焦点消息!西安有情天聊天室登录_西安有情天聊天室

1、推荐兄弟去青草地聊天室,你是西安的就进西安的城市频道就行了,是

-

优土视频(可见优土功能)_全球今亮点

来为大家解答以上的问题。优土视频,可见优土功能这个很多人还不知道,

-

当前快看:打通“断头路” 跑出“加速度”

交通是城市的脉络,一条条宽阔的道路宛如一条条灵动的生命线,承载着一

-

全球报道:默里生涯前四场总决赛每场10+助攻 成NBA历史第一人

央视网消息:北京时间6月10日,NBA总决赛第四场,掘金客场108-95击败热

-

淮安:205国道京杭运河特大桥 雄伟壮观 助力腾飞_环球快资讯

205国道京杭运河特大桥位于市区205国道上,由北向南先后跨越里运河、京

-

居理买房暴雷!前员工称“欠薪千万元,丈母娘顶替法人”

居理买房暴雷!前员工称“欠薪千万元,丈母娘顶替法人”

-

3系换什么避震好(3系用什么避震?) 世界热头条

相信大家对3系换什么避震好,3系用什么避震?的问题都很疑惑,这个问题

-

如何避免dxgmms1.sys蓝屏问题|今日快讯

很多小伙伴还不会操作这款软件,用户求助最多的就是dxgmms1 sys蓝屏解

-

窒息灭火法是指什么_窒息灭火法

1、按照燃烧原理,一切灭火方法的原理是将灭火剂直接喷射到燃烧的物体

-

您好,2023.2.27我在一个网上购物平台买了一件物品,价值4 当前观察

您好,2023 2 27我在一个网上购物平台买了一件物品,价值4

-

lol豹女视频s7_lol豹女视频

1、她是德玛西亚阵营的。2、生活在南美洲森林。以上就是【lol豹女视频s

-

【热闻】5月国内挖掘机销量降46%,出口增速重回两位数|基建晴雨表

界面新闻记者|马悦然今年以来,国内挖掘机销量持续同比下滑。6月7日晚

-

黑皮诺和赤霞珠哪个后劲大? 环球速讯

赤霞珠后劲大,因为是红葡萄酒用黑皮诺酿制的红葡萄酒是勃艮第(Burgun

-

何处招魂香草还生三户地说的是谁(何处招魂香草还生三户地)

1、长沙屈原祠对联: “何处招魂,香草还生三户地;当年呵壁,湘流

-

云端翔龙骑士团声望怎么刷快(云端翔龙骑士团声望怎么刷)

1、最快的是交龙蛋,和70的时候虚空龙一样,在临风岛捡龙蛋交就行。2、

-

超音速巡航的战斗机(超音速巡航)

来为大家解答以上的问题。超音速巡航的战斗机,超音速巡航这个很多人还

X 关闭

X 关闭